프로그램 신청

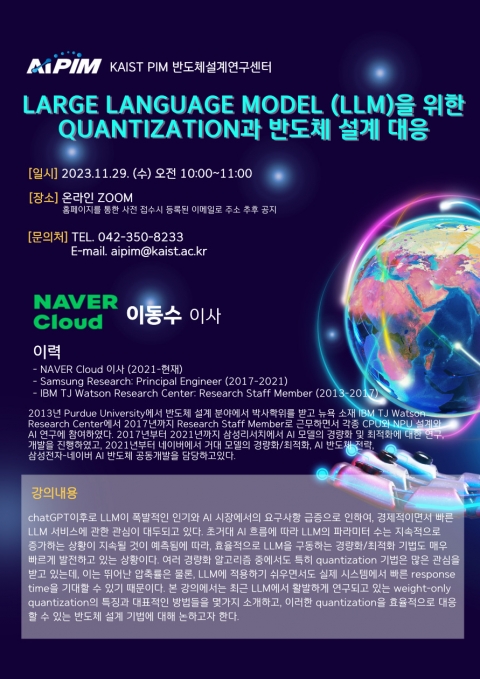

Large Language Model (LLM)을 위한 quantization과 반도체 설계 대응

-

교육기간2023.11.29. 10:00(수) ~ 2023.11.29. 11:00(수)

-

모집기간2023.11.13. 00:00(월) ~ 2023.11.27. 00:00(월)

-

모집방법관리자 승인

-

수강대상학부 및 대학원생

-

교육인원제한없음

-

교육장소온라인 ZOOM (사전 접수시 등록된 이메일로 주소 추후 공지)

-

모집상태교육종료

-

수료증미발급

상세정보

1. 강의일정

1) 일시 : 11월 29일(수)/오전 10:00 ~ 11:00

2) 장소 : 온라인 ZOOM (사전 접수시 등록된 이메일로 주소 추후 공지)

2. 수강대상 : 학부 및 대학원생

3. 강의내용

*네이버클라우드 이동수 이사

chatGPT이후로 LLM이 폭발적인 인기와 AI 시장에서의 요구사항 급증으로 인하여, 경제적이면서 빠른 LLM 서비스에 관한 관심이 대두되고 있다. 초거대 AI 흐름에 따라 LLM의 파라미터 수는 지속적으로 증가하는 상황이 지속될 것이 예측됨에 따라, 효율적으로 LLM을 구동하는 경량화/최적화 기법도 매우 빠르게 발전하고 있는 상황이다. 여러 경량화 알고리즘 중에서도 특히 quantization 기법은 많은 관심을 받고 있는데, 이는 뛰어난 압축률은 물론, LLM에 적용하기 쉬우면서도 실제 시스템에서 빠른 response time을 기대할 수 있기 때문이다. 본 강의에서는 최근 LLM에서 활발하게 연구되고 있는 weight-only quantization의 특징과 대표적인 방법들을 몇 가지 소개하고, 이러한 quantization을 효율적으로 대응할 수 있는 반도체 설계 기법에 대해 논하고자 한다.

4. 포스터